DeepSeek API 文档一起了解下如何使用,数字先锋聚合大模型API接入平台早已支持DeepSeek API使用

API接口网址 https://api.cxhao.com

DeepSeek API 使用与 OpenAI 兼容的 API 格式,通过修改配置,您可以使用 OpenAI SDK 来访问 DeepSeek API,或使用与 OpenAI API 兼容的软件。

| PARAM | VALUE | ||

|---|---|---|---|

| base_url * |

|

||

| api_key | apply for an API key |

* 出于与 OpenAI 兼容考虑,您也可以将

1 | base_url |

设置为

1 | https://api.deepseek.com/v1 |

来使用,但注意,此处

1 | v1 |

与模型版本无关。

*

1 | deepseek-chat |

模型已全面升级为 DeepSeek-V3,接口不变。 通过指定

1 | model='deepseek-chat' |

即可调用 DeepSeek-V3。

*

1 | deepseek-reasoner |

是 DeepSeek 最新推出的推理模型 DeepSeek-R1。通过指定

1 | model='deepseek-reasoner' |

,即可调用 DeepSeek-R1。

调用对话 API

在创建 API key 之后,你可以使用以下样例脚本的来访问 DeepSeek API。样例为非流式输出,您可以将 stream 设置为 true 来使用流式输出。

CRUL示例

1 2 3 4 5 6 7 8 9 10 11 | curl https://api.deepseek.com/chat/completions \ -H "Content-Type: application/json" \ -H "Authorization: Bearer " \ -d '{ "model": "deepseek-chat", "messages": [ {"role": "system", "content": "You are a helpful assistant."}, {"role": "user", "content": "Hello!"} ], "stream": false }' |

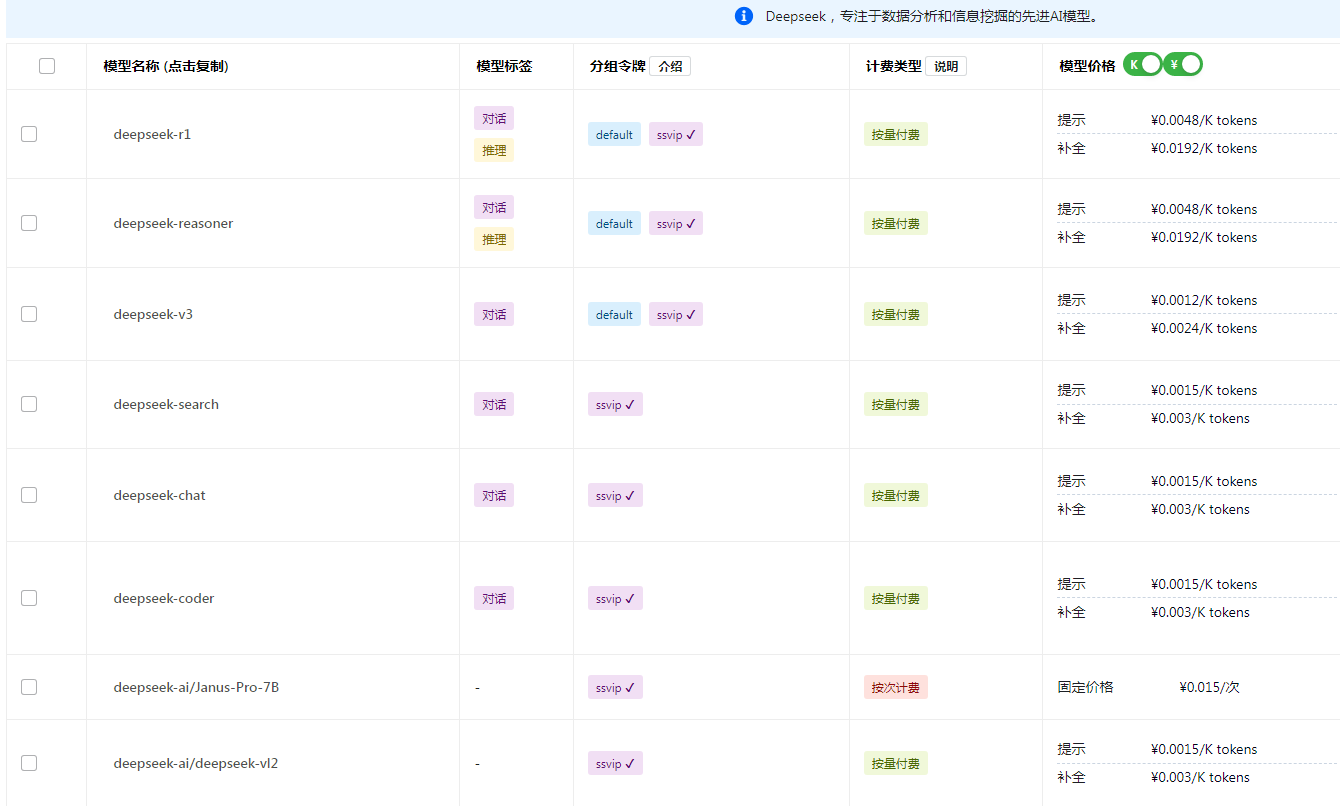

模型 & 价格

| 模型(1) | 上下文长度 | 最大思维链长度(2) | 最大输出长度(3) | 百万tokens 输入价格 (缓存命中)(4) |

百万tokens 输入价格 (缓存未命中) |

百万tokens 输出价格 输出价格 |

|---|---|---|---|---|---|---|

| deepseek-chat | 64K | - | 8K | 0.1元 |

1元 |

2元 |

| deepseek-reasoner | 64K | 32K | 8K | 1元 | 4元 | 16元(6) |

扣费规则

扣减费用 = token 消耗量 × 模型单价,对应的费用将直接从充值余额或赠送余额中进行扣减。 当充值余额与赠送余额同时存在时,优先扣减赠送余额。

Temperature 设置

1 | temperature |

参数默认为 1.0。

- 我们建议您根据如下表格,按使用场景设置

1temperature

。

| 场景 | 温度 |

|---|---|

| 代码生成/数学解题 | 0.0 |

| 数据抽取/分析 | 1.0 |

| 通用对话 | 1.3 |

| 翻译 | 1.3 |

| 创意类写作/诗歌创作 | 1.5 |

Token 用量计算

token 是模型用来表示自然语言文本的基本单位,也是我们的计费单元,可以直观的理解为“字”或“词”;通常 1 个中文词语、1 个英文单词、1 个数字或 1 个符号计为 1 个 token。

一般情况下模型中 token 和字数的换算比例大致如下:

- 1 个英文字符 ≈ 0.3 个 token。

- 1 个中文字符 ≈ 0.6 个 token。

但因为不同模型的分词不同,所以换算比例也存在差异,每一次实际处理 token 数量以模型返回为准,您可以从返回结果的

1 | usage |

中查看。

离线计算 Tokens 用量

您可以通过如下压缩包中的代码来运行 tokenizer,以离线计算一段文本的 Token 用量。

限速

DeepSeek API 不限制用户并发量,我们会尽力保证您所有请求的服务质量。

但请注意,当我们的服务器承受高流量压力时,您的请求发出后,可能需要等待一段时间才能获取服务器的响应。在这段时间里,您的 HTTP 请求会保持连接,并持续收到如下格式的返回内容:

- 非流式请求:持续返回空行

- 流式请求:持续返回 SSE keep-alive 注释(

1: keep-alive

)

这些内容不影响 OpenAI SDK 对响应的 JSON body 的解析。如果您在自己解析 HTTP 响应,请注意处理这些空行或注释。

如果 30 分钟后,请求仍未完成,服务器将关闭连接。

错误码

您在调用 DeepSeek API 时,可能会遇到以下错误。这里列出了相关错误的原因及其解决方法。

| 错误码 | 描述 |

|---|---|

| 400 - 格式错误 | 原因:请求体格式错误 解决方法:请根据错误信息提示修改请求体 |

| 401 - 认证失败 | 原因:API key 错误,认证失败 解决方法:请检查您的 API key 是否正确,如没有 API key,请先 创建 API key |

| 402 - 余额不足 | 原因:账号余额不足 解决方法:请确认账户余额,并前往 充值 页面进行充值 |

| 422 - 参数错误 | 原因:请求体参数错误 解决方法:请根据错误信息提示修改相关参数 |

| 429 - 请求速率达到上限 | 原因:请求速率(TPM 或 RPM)达到上限 解决方法:请合理规划您的请求速率。 |

| 500 - 服务器故障 | 原因:服务器内部故障 解决方法:请等待后重试。若问题一直存在,请联系我们解决 |

| 503 - 服务器繁忙 | 原因:服务器负载过高 解决方法:请稍后重试您的请求 |

API 调用问题

调用模型时的并发限制是多少?是否可以提高账号的并发上限?

当前阶段,我们没有按照用户设置硬性并发上限。在系统总负载量较高时,基于系统负载和用户短时历史用量的动态限流模型可能会导致用户收到 503 或 429 错误码。

目前暂不支持针对单个账号提高并发上限,感谢您的理解。

为什么我感觉 API 返回比网页端慢

网页端默认使用流式输出(stream=true),即模型每输出一个字符,都会增量地显示在前端。

API 默认使用非流式输出(stream=false),即模型在所有内容输出完后,才会返回给用户。您可以通过开启 API 的 stream 模式来提升交互性。

为什么调用 API 时,持续返回空行?

为了保持 TCP 连接不会因超时中断,我们会在请求等待调度过程中,持续返回空行(非流式请求)或 SSE keep-alive 注释(

1 | : keep-alive |

,流式请求)。如果您在自己解析 HTTP 响应,请注意处理这些空行或注释。

是否支持 LangChain?

支持。LangChain 支持 OpenAI API 接口,而 DeepSeek API 接口与 OpenAI 兼容。您可以下载以下代码文件并替换代码中的 API Key,实现在 LangChain 中调用 DeepSeek API。

评论(0)