这段时间DeepSeek是非常火,APP也免费提供使用了,DeepSeek和ChatGPT各有自己的优势,具体表现取决于使用场景。全面测试对DeepSeek与ChatGPT比较。deepseek对接API接口时继承了OpenAI兼容的格式,最新发布的deepseek-R1模型也属于推理高级模型也能接入API使用了,DeepSeek数学与编程能力在文字总结方面表现出色,响应速度两者差不多,上下文理解能力ChatGPT长时间对话中表现更佳,成本与开放性方便DeepSeek以低成本高效能著称,并且是开源模型,ChatGPT非开源,成本使用相对较高。文章写作时DeepSeek提供了更多实质性的论据和数据支持(只有推理模型支持),而ChatGPT的文笔简洁,结构清晰然而在图形处理、翻译等其他领域,DeepSeek的表现不如ChatGPT。ChatGPT则以其强大的对话生成能力和多样的翻译能力脱颖而出,无论是在日常交流、写代码、改代码、学术翻译还是创意写作中,都展现了强大的潜力。

大家最关心的是如何修改自己的ChatGPT创作付费系统接口,DeepSeek API 使用与 OpenAI 兼容的 API 格式,通过修改配置,您可以使用 OpenAI SDK 来访问 DeepSeek API,或使用与 OpenAI API 兼容的软件。

| PARAM | VALUE | ||

|---|---|---|---|

| base_url * |

|

||

| api_key | apply for an API key |

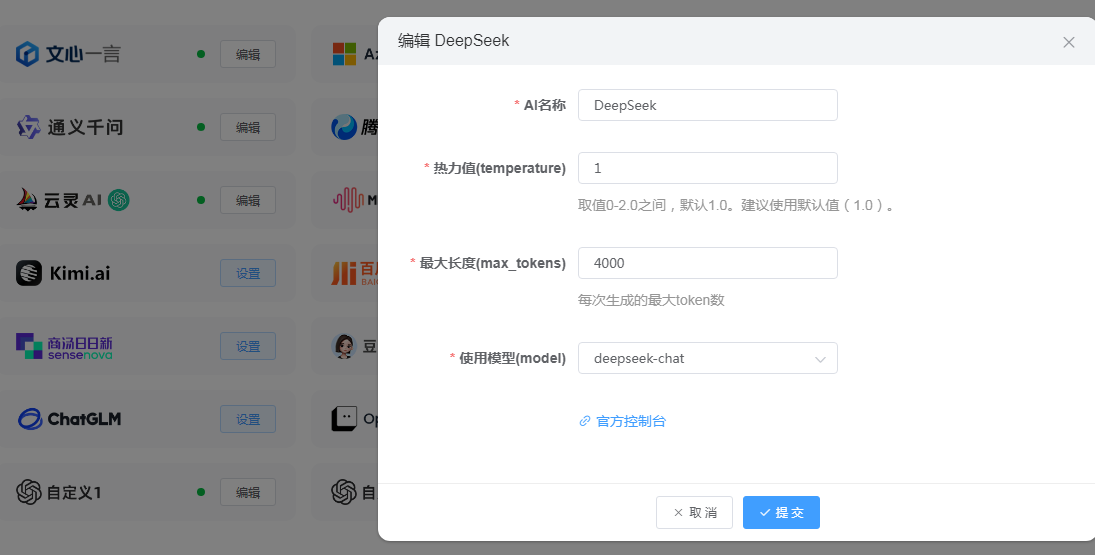

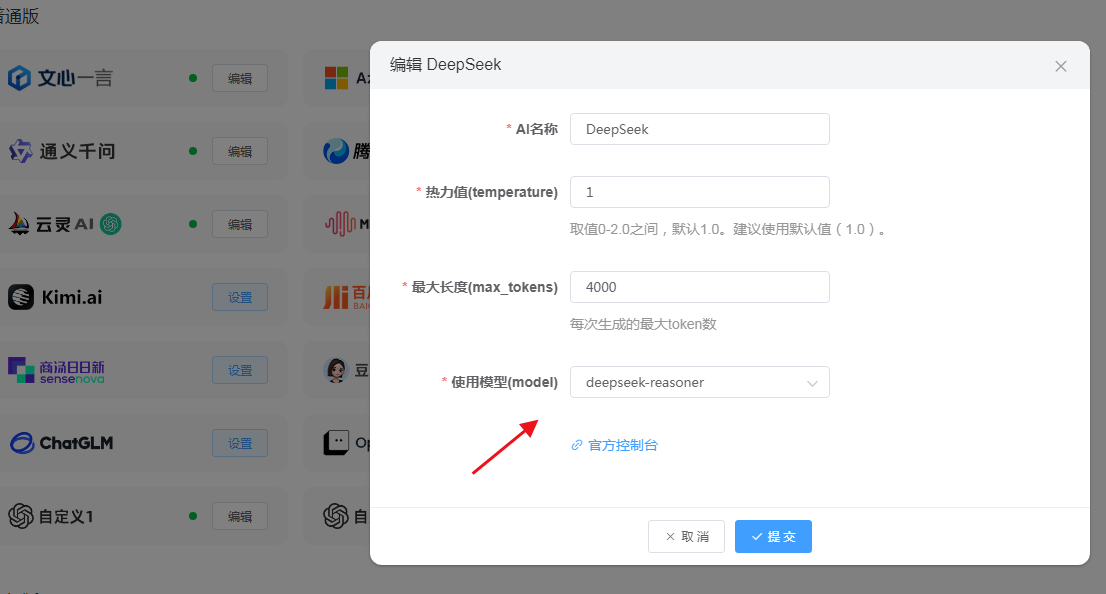

如果只是使用deepseek-chat模型可以默认不用修改,现成就能使用,默认是调用DeepSeek-V3模型

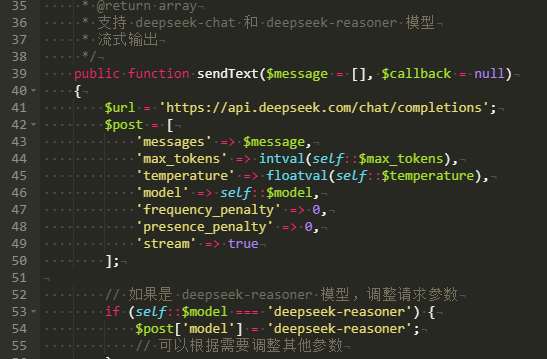

如果是需要接入推理模型 (deepseek-reasoner)就没戏了,原来想改下数据库模型名称,再改加下代码就可以用看来实现不了,不过费事了这么多还是把修改后的代码附上

还有个选择用使用百度千帆的DeepSeek接口实现deepseek-r1接口,具体自行研究看

/extend/ChatGPT/deepseek.php 51行加上供参考

1 2 3 4 5 | // 如果是 deepseek-reasoner 模型,调整请求参数 if (self::$model === 'deepseek-reasoner') { $post['model'] = 'deepseek-reasoner'; // 可以根据需要调整其他参数 } |

看看要求要玩推理模型只能部署本地玩了,以下是将 DeepSeek-R1 大语言模型部署到服务器所需的 完整环境配置,涵盖硬件、软件、依赖库及网络要求:

一、硬件环境要求

1. GPU 配置(核心)

- 显存要求:

- 单卡场景:至少 NVIDIA A100 80GB(千亿参数模型需显存 ≥80GB)。

- 多卡场景:支持 NVIDIA A100/H100 多卡并行(需显存总量 ≥80GB,推荐 2×A100 80GB)。

- 计算能力:GPU 架构需为 Ampere 或更新(如 A100、H100、RTX 4090 等),CUDA Compute Capability ≥8.0。

2. CPU 与内存

- CPU:

- 推荐 Intel Xeon 或 AMD EPYC 系列,16 核以上(需支持 AVX-512 指令集)。

- 内存:

- 最低 128GB DDR4,推荐 256GB+(用于处理长上下文和中间计算缓存)。

3. 存储

- 硬盘空间:

- 模型文件:约 200–300GB(FP16 精度,含分词器和配置文件)。

- 系统与缓存:额外预留 100GB+ SSD/NVMe 空间。

- IO 速度:推荐 NVMe SSD,读写速度 ≥3GB/s。

环境也要安装ollama才支持,折腾了2天放弃,由于DeepSeek官方API经常遭受攻击或者繁忙不可用,所以建议使用第三方部署的deepseek-r1接口,有硬件资源的也可以自己本地部署。

还有种访求使用百度千帆的DeepSeek接口调用。

-----------------------------------------------------------------

方式一:百度千帆的DeepSeek接口调用

进入千帆控制台->应用管理,创建一个应用,复制 应用ID 到后台,进入API Key管理页,创建一个key,复制到后台

-------------------------------------------------------------------

方式二:本地部署deepseek-r1文档

第1步:安装ollama

官方下载地址:https://ollama.com,下载安装。

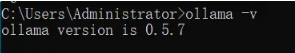

安装完在cmd里运行 ollama -v ,能正确显示版本号就表示安装成功了

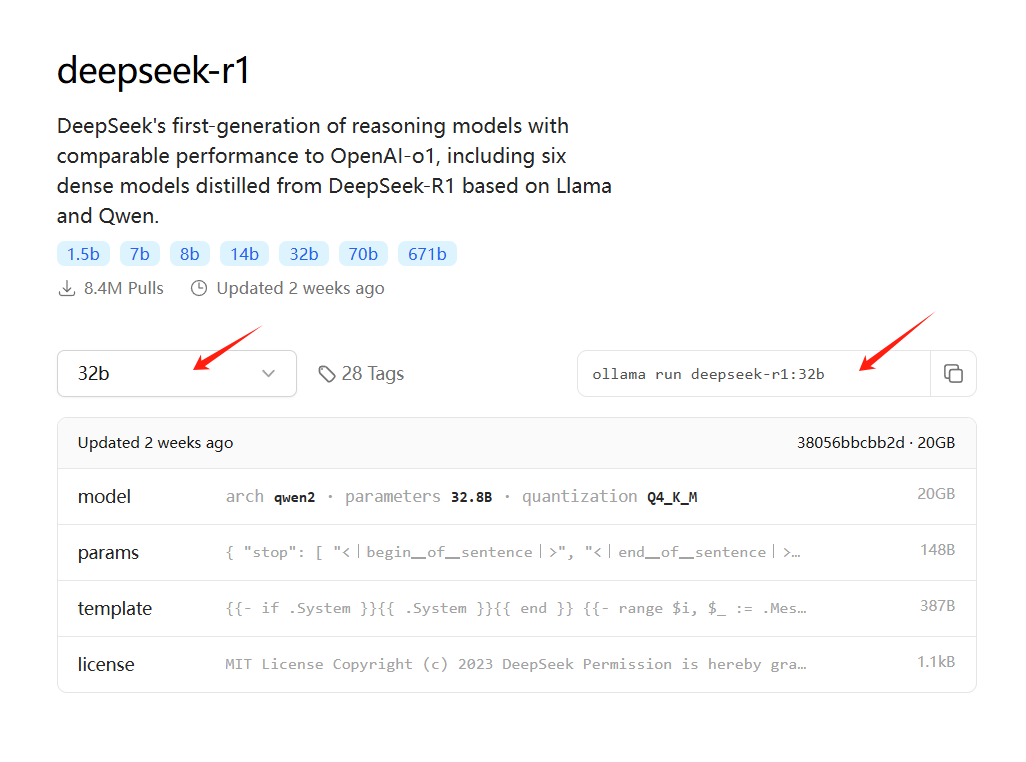

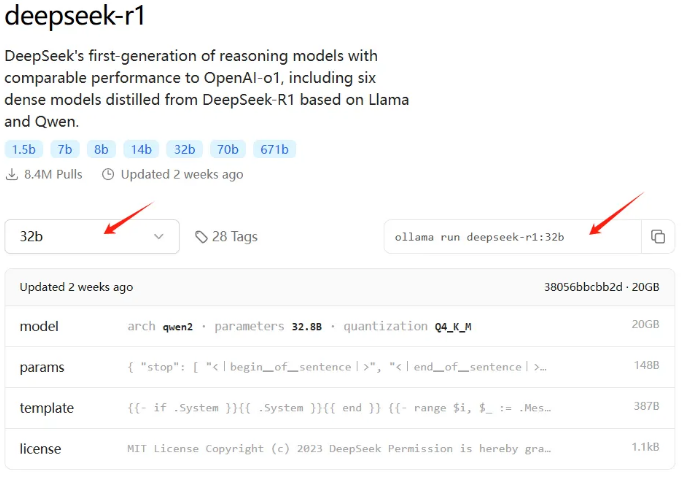

第2步:运行模型(仅需1条命令)

进入 ollama 的 deepseek-r1 介绍页面,根据自己的硬件情况,选择一个合适的版本,复制命令到cmd运行即可(建议32b及以上)

https://ollama.com/library/deepseek-r1:32b

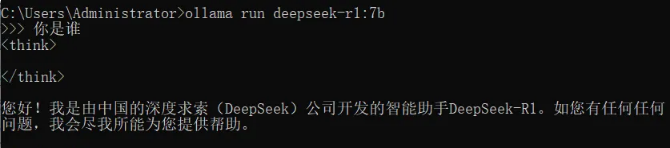

例如7b模型: ollama run deepseek-r1:7b

首次运行会自动下载模型(最后1%下载很慢,可 ctrl+c 中断后重新运行命令,续传就快了)

运行完命令可在控制台直接对话,如下图(Windows),linux同样的命令:

第3步:将API地址配置到后台

Ollama默认服务端口是11434,其提供的OpenAI格式的API地址为:

http://[ip地址]:11434/v1/chat/completions

将此地址填到后台就可以在线调用了(只适用最新版,老版改下代码)

最后,附几个ollama常用命令:

ollama -v :查看ollama版本号

ollama run [模型名称] :运行一个模型

ollama serve :启动ollama服务

ollama list :列出本地所有可用的模型

ollama rm [模型名称] :删除一个已安装的模型

评论(0)